Derin Öğrenme ve Temel Bileşenlerini Sezgisel Yolla Anlamak

Derin öğrenme tıptan fiziğe, büyük dil modellerinden otonom araçlara kadar hayatımızın birçok alanında yer edinmiş bir konudur. Bu yazı, derin öğrenme ve temel bileşenlerine sezgisel açıklamalar sunmaktadır. Uzaktan bakıldığında göz korkutucu görünebilen bu temel bileşenlere dayanan konseptleri sade ve anlaşılır bir şekilde öğrenmek, özellikle proje geliştirme aşamalarında, büyük bir önem taşımaktadır.

Derin öğrenme nedir?

Tanımlamaya geçmeden önce yapay zekâ ve makine öğrenmesinin tanımlarını yapmak konunun daha kolay anlaşılmasına yardımcı olacaktır. Çünkü derin öğrenme makine öğrenmesinin bir alt başlığıdır; makine öğrenmesi ise yapay zekânın bir alt dalıdır.

- Yapay Zekâ: İnsan davranışlarını taklit ederek karar verme, öğrenme ve problem çözme gibi işlevleri yerine getiren sistemlerdir.

- Makine Öğrenmesi: Yapay zekânın bir alt dalı olan makine öğrenmesi, veri setlerinden öğrenerek kararlar almak için istatistiksel algoritmalar kullanır.

- Derin Öğrenme: Makine öğrenmesinin bir alt dalı olan derin öğrenme, öğrenme sürecini yapay sinir ağları aracılığıyla gerçekleştirir. Bu ağlar veriden daha karmaşık özellikler çıkarmaya olanak tanır. Diğer makine öğrenmesi yöntemlerinden farklı olarak daha az özellik mühendisliği müdahalesiyle verinin karmaşık yapılarını daha soyut ve etkili bir şekilde öğrenebilir.

Yapay sinir ağları günümüzde en yaygın kullanılan teknolojilerden biri haline gelmiş ve hayatımızın birçok alanında karşımıza çıkmaktadır. En popüler olarak Python programlama diliyle geliştirilir; PyTorch, TensorFlow ve Keras kütüphaneleri ise en yaygın kullanılan araçlar arasında yer alır. Derin öğrenme algoritmaları her geçen gün daha güçlü ve verimli hale gelmektedir. Bu gelişimin arkasında yazılımda yaşanan ilerlemeler kadar özellikle donanımdaki gelişmeler—GPU'lar ve bulut teknolojilerindeki—ve veri miktarındaki artış da derin öğrenmenin yaygınlaşmasında rol oynayan kritik parametrelerdir.

Modeller, klasik makine öğrenmesi yöntemlerine kıyasla daha az insan müdahalesi gerektirir; zira bu modeller veriden doğrudan öğrenerek genellikle ham veri üzerinde çalışır. Bu özelliği nedeniyle derin öğrenme modelleri bazen “kara kutu” olarak adlandırılırlar. Son yıllarda veri miktarındaki hızlı artış derin öğrenme modellerinin daha da etkili hale gelmesine büyük katkı sağlamıştır. Projelerinizde kendi modellerinizi eğitebileceğiniz gibi aynı zamanda önceden büyük veri setleriyle eğitilmiş ve erişime sunulmuş modellerden de faydalanabilirsiniz.

Derin öğrenmedeki “öğrenme” sürecini daha anlaşılır bir şekilde açıklamak faydalı olacaktır. Diyelim ki bir müzik türü sınıflandırma projesi üzerinde çalışıyoruz ve amacımız modelimize sunduğumuz yeni müzik parçalarını doğru bir şekilde sınıflandırmak. İnsanlar bir müzik parçasını dinlerken daha önce duydukları benzer parçaları referans alarak ve o an dinledikleri parçanın dokusunu inceleyerek hangi türe ait olduğunu anlamlandırabilirler. Örneğin, punk rock bir parça çaldığında daha önce dinlediğimiz benzer parçalara ve türün diğer özelliklerine dayanarak bu parçanın türünü kolayca çıkarabiliriz. Derin öğrenme modelleri de yapay sinir ağlarını kullanarak benzer şekilde çalışır. Ne kadar çok müzik parçası modelimize sunulursa o kadar doğru sınıflandırmalar yapılabilir. “Derin” terimi ise yapay sinir ağlarındaki çok katmanlı yapıyı ve gizli katmanların fazlalığını ifade eder. Takip eden alt başlıkta katmanlar ve diğer temel bileşenler sezgisel bir şekilde tanımlanmaktadır.

Derin Öğrenmenin Temel Bileşenleri

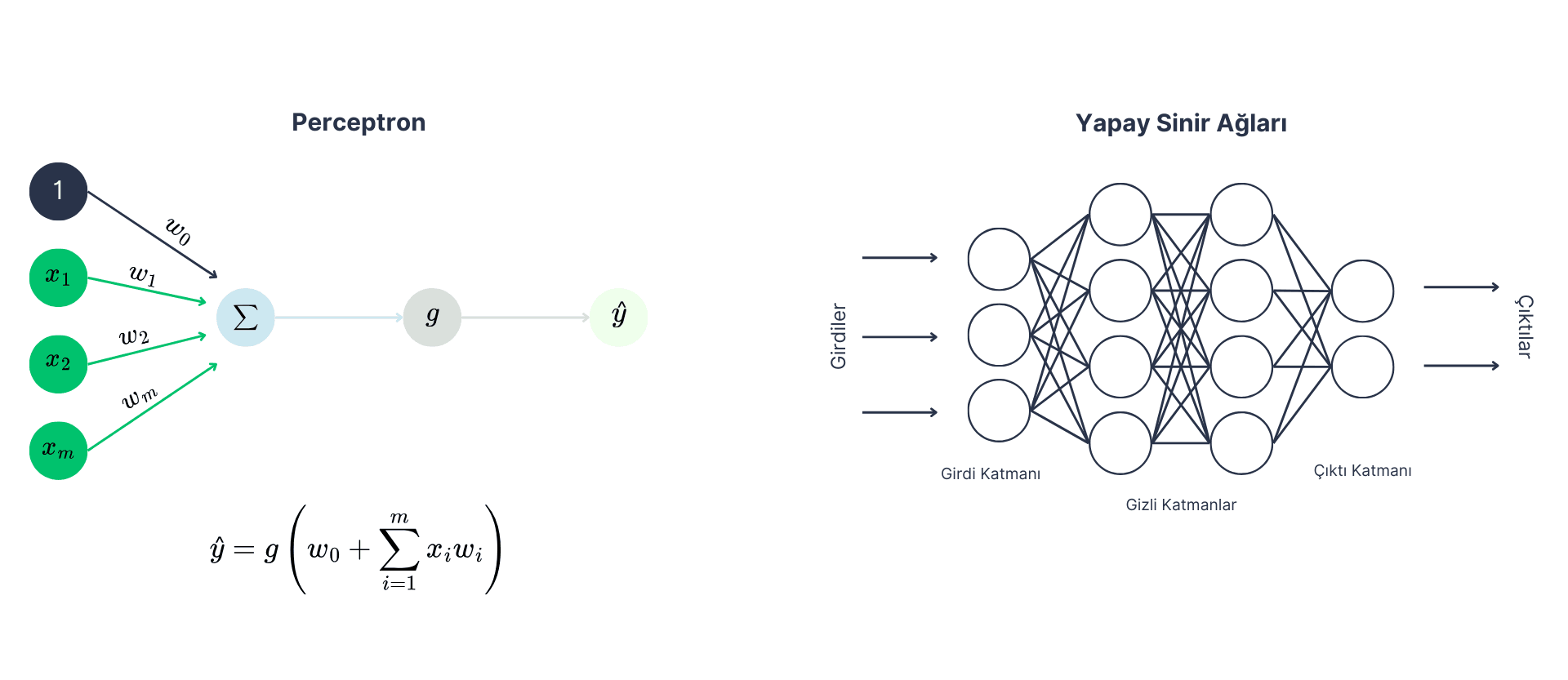

Fazlasıyla dinamik olan bu alanda kullanılan yapay sinir ağlarının temellerini anlamak, doğru model geliştirebilmek ve uygulamaları verimli hale getirebilmek için kritik bir rol oynamaktadır. Yapay sinir ağları birden çok perceptronun katmanlar halinde düzenlendiği, veriyi işleyerek sonuçlar üreten yapay zekâ modelidir. Her katman, belirli bir işlevi yerine getirir ve veri ağın içinden geçerken giderek daha karmaşık özellikleri öğrenir. Bu ağlar, sınıflandırma, regresyon, özellik çıkarımı ve daha birçok problem için kullanılabilir.

- Perceptron: Yapay sinir ağlarının temel yapı taşıdır ve tek bir nöron olarak düşünülebilir. Her bir perceptron, giriş verilerini işler ve bu veriler üzerinde giriş verisi ile ağırlıkların çarpımı ve sabit terimin eklenmesi şeklinde bir hesaplama yapar. Elde edilen değer bir aktivasyon fonksiyonundan geçirilir ve çıktı olarak üretilir. Bu çıktı bir sonraki katman için giriş olarak kullanılabilir. Örneğin, müzik türü sınıflandırma projesindeki her bir perceptron, bir müzik parçasının farklı özelliklerine (örneğin tempo, ton) ağırlık vererek bu parçayı sınıflandırmaya yardımcı olur.

- Katman: Yapay sinir ağlarında bir katman birden çok perceptronun bir araya gelerek oluşturduğu bir yapıdır. Her bir katman giriş verisini işler ve bu veriyi bir sonraki katmana iletmek için çıktılar üretir. Genellikle üç ana katman bulunur: giriş katmanı, gizli katmanlar ve çıkış katmanı. Müzik türü sınıflandırma örneğinde, giriş katmanı müzik parçasının temel özelliklerini alırken, gizli katmanlar daha derin öğrenme yaparak bu özellikleri anlamlı sınıflara dönüştürür.

- Ağırlıklar ve Sabit Değer (wm ve w0): Yapay sinir ağlarında her bir perceptron giriş verilerini işler ve bu veriler üzerinde belirli ağırlıklar ve sabit değer kullanılır. Ağırlıklar, giriş verilerinin model için önemini belirlerken, sabit değer ise modelin tahminlerini daha esnek hale getirmek için kullanılır. Ağırlıklar ve sabit değer, perceptronları oluşturmak için bir araya gelir ve sinir ağları üzerindeki öğrenme sürecinin temelini atar.

- Aktivasyon Fonksiyonu (g): Yapay sinir ağlarındaki her nöronun çıkışını belirleyen matematiksel bir işlevdir. Genellikle modelin doğrusal olmayan yapısını sağlamada kullanılır çünkü gerçek dünya veriler çoğu zaman doğrusal olmayan ilişkiler içerir. Aktivasyon fonksiyonları arasında sigmoid, ReLU ve hiperbolik tanjant gibi fonksiyonlar bulunur. Bu fonksiyonlar, ağın daha karmaşık ve doğrusal olmayan verileri öğrenmesini mümkün kılar.

- Kayıp Fonksiyonu (Loss Function): Modelin tahmin ettiği değerlerle gerçek değerler arasındaki farkı ölçen bir fonksiyondur. Bu farkı minimize etmek, yani modelin hata oranını en aza indirmek, hedeflenir. Eğitim sürecinde model, tahmin ettiği müzik türleriyle gerçek müzik türlerinin ne kadar örtüştüğünü hesaplar ve bu farkı minimize etmeye çalışır. Loss fonksiyonu, modelin doğruluğunu artırmak için optimize edilmesi gereken bir kritere dönüşür.

- Optimizasyon Algoritmaları: Gradient descent kayıp fonksiyonunu minimize etmek için kullanılan bir optimizasyon algoritmasıdır. Temelde kayıp fonksiyonunun türevini alarak minimum değere ulaşmak için ağırlıkları günceller. Bu algoritmanın amacı modelin tahmin hatalarını minimize etmektir. Gradient descent, farklı türlerde uygulanabilir: batch gradient descent, stochastik gradient descent ve mini-batch gradient descent gibi çeşitleri bulunur.

- Regularizasyon Teknikleri: Overfitting, modelin eğitim verisine çok iyi uyum sağlaması ancak gerçek dünya verisine genellendiğinde düşük performans göstermesi durumudur. Bu problem engellemek için derin öğrenme modellerinde dropout, early stopping gibi yöntemler kullanılır. Müzik türü sınıflandırmasında da modelin sadece eğitim verilerine değil gerçek dünya müziklerine de uyum sağlaması gerektiğinden bu teknikler modelin genel başarısını artırmak için önemlidir.

Birçok model bu konseptlere dayanarak çalışır ve derin öğrenme modelleri insan beynini bu şekilde referans alarak geliştirilmiştir. Birkaç yıl önce şu anki maliyetlerin daha yüksek olacağı öngörülürken uygulamaların maliyetleri beklenenden çok daha düşük seviyelere indi. GPU'lara yapılan yatırımlar ve gelişmeler, veri yükünün her geçen gün artmasıyla birlikte bu temel konseptlere dayanan modellerin yakın gelecekte daha da yaygın hale geleceğini gösteriyor olabilir.